编者按: 我们正在进入一个智能时代, 智能技术正在对人们的工作和生活等方面产生深刻的影响。工程心理学在新的智能时代的作用日益明显。为此, 时隔两年, 本刊主编再次邀请浙江大学心理科学研究中心研究员许为博士和浙江大学心理科学研究中心教授葛列众博士撰写《智能时代的工程心理学》一文。文章系统地提出了智能时代工程心理学的工作框架, 对智能时代的工程心理学研究和应用的对象、学科理念、研究重点、应用范围、方法等方面做了许多有意义的新的思考和论述, 并对智能时代工程心理学研究和应用提出了展望。许为和葛列众博士均是中国工程心理学和人因学开拓者朱祖祥先生的学生, 多年来始终潜心工程心理学研究, 取得了不少研究成果, 希望此文对从事工程心理学及相关领域的研究者有所启发。

虽然国内工程心理学和人因学(Human Factors)的发展起步较晚, 但是在过去的30多年中迅速发展, 特别是计算机信息技术的发展有力地推动了学科的研究和应用, 为国民经济各方面做出了突出的贡献(朱祖祥, 2003; 葛列众, 李宏汀, 王笃明, 2017)。近几年有多篇文章综述了中国工程心理学和人因学的发展现状, 并对今后的发展提出了展望(例如, 孙向红 等, 2011; 许为, 葛列众, 2018)。

目前, 我们正在进入智能时代, 智能技术正在对人机关系、人机交互、人们的工作和生活等方面产生深刻的影响。因此, 有必要进一步分析智能技术的新特征, 评估智能技术对工程心理学和人因学(以下简称为工程心理学)研究以及应用的对象、重点、方法等方面所带来的影响, 展望今后的工作, 从而更好地发挥工程心理学在智能时代的影响力。

1 智能时代的工程心理学特征

1.1 智能技术的时代特征

表1 AI的三次浪潮和发展的阶段特征(来源: 许为, 2019b)

| 第一次浪潮(上世纪50~70年代) | 第二次浪潮(上世纪80~90年代) | 第三次浪潮(2006年~ ) | |

|---|---|---|---|

| 主要技术和方法 | 早期“符号主义和联结主义”学派, 产生式系统, 知识推理, 专家系统 | 统计模型在语音识别、机器翻译的研究, 神经网络的初步应用, 专家系统 | 深度学习技术在语音识别、数据挖掘、自然语言处理、模式识别等方面的突破, 大数据, 计算力等 |

| 用户需求 | 无法满足 | 无法满足 | 开始提供有用的、解决实际问题的AI应用解决方案 |

| 工作重点 | 技术探索 | 技术提升 | 技术提升, 应用落地场景, 伦理化设计, 前端应用, 人机交互技术等 |

| 阶段特征 | 学术主导 | 学术主导 | 技术提升+应用+以人为中心 |

1.2 智能技术的工程心理学特征: 从自动化到自主化

自动化(automation)与自主化(autonomy)分别代表了非智能技术与智能技术的典型特征, 对这些特征的分析可以清楚地揭示非智能技术与智能技术的工程心理学问题和工作思路。

1.2.1 自动化技术的教训

自动化系统通常依赖于固定的逻辑规则和算法来执行定义好的任务, 并产生确定的操作结果。它的操作需要人类操作员启动、设置控制模式以及编制任务计划等。在一些设计无法预料的操作场景或应急状态时, 需要人工干预来控制系统的运行。自动化不能完全取代人类操作员的岗位, 但是它将人类工作的性质从直接操作转变为更具监控的操作。例如, 大型民用飞机驾驶舱中, 自动化系统可以完成几乎所有飞行阶段的任务 (起飞以外), 飞行员的主要任务是监控飞行操作。但是, 在应急状态时, 仍然需要驾驶员立刻断开自动飞行系统, 人工干预接管对飞机的操控。

在过去的30多年中, 工程心理学已经对一些复杂领域(航空, 航天, 核电等)中的人-自动化交互开展了广泛的研究, 评估自动化技术、人机交互设计、人员培训和操作等因素对操作员的情境意识(SA)、自动化模式识别、心理模型、警戒水平、信任、工作负荷、工作绩效等的影响, 并且取得了大量的研究结果(Sarter & Woods, 1995; Endsley, 2017; 许为, 2003a; Mumaw, Boonman, Griffin, & Xu, 1999)。自动化操作中的监控作业虽然减少了操作员的体力工作负荷, 但实际上会提高认知工作负荷(Grubb et al., 1994), 导致操作员警戒水平降低和SA的下降(Hancock, 2013), 产生过度信任(自满)、过度依赖自动化(Parasuraman & Riley, 1997)、诊断问题准确性和效率降低等问题。这些问题导致在应急状态中可能会做出错误的人工干预(Endsley, 2015)。也有研究发现许多自动化系统存在脆弱性, 在设计所规定的操作情况下系统运行良好, 但是在遇到意外事件需要人工干预时, 会导致操作员的“自动化惊讶” (automation surprise)问题: 即操作员可能无法理解自动化正在做什么, 为什么要这样做(Sarter & Woods, 1995; Sarter et al., 2003)。

Bainbridge (1983)曾经提出了一个经典的“自动化的讽刺” (ironies of automation)现象: 自动化程度越高, 操作员的介入越少, 对系统的关注度就越低, 在应急状态下, 操作员就越不容易通过人工干预来操控系统。自动化技术的这些工程心理学问题给操作员的工作绩效和系统安全带来了挑战。在民用航空领域, 驾驶舱自动化直接或间接地导致了许多起重大飞行事故(Endsley, 2015; 许为, 2017)。自动化问题的出现和被人们充分认识经历了一个长期的过程, 但是经典的“自动化的讽刺”现象在30多年后仍然没有得到彻底的解决(Strauch, 2017)。2018和2019年发生的两起与驾驶舱自动化有关的波音737 MAX飞机坠机事故就是一个佐证。

1.2.2 自主化技术的工程心理学特征

自动化技术已经触碰到了其发展的“天花板”, 尤其当遇到设计事先无法预料的操作场景时, 人们需要自适应、智能化、更高水平的“自动化”系统, 基于AI、深度学习、大数据等技术的智能系统应运而生。不同于非智能系统的自动化技术, 智能系统的核心技术特征是自主化。带有自主化特征的智能系统具有一定程度的认知学习、自适应等能力, 在特定的场景下可以自主地完成独立于人工干预的一些特定任务。目前, 越来越多的智能自主化系统(autonomous systems)开始投入使用或者正在被开发。例如, 采用软件自主代理和基于语音输入的智能音箱, 智能决策支持系统, 大型智能无人机, 智能机器人, 自动驾驶车(具有高等级自动驾驶功能), 空间行走机器人(月球车等), 自主武器系统, 甚至包括网上自主传播的Stuxnet病毒软件等。

表2比较了基于自动化的非智能系统与基于自主化的智能系统之间的工程心理学特征。不同于自动化, 具有自主化特征的智能系统拥有自我学习等认知能力, 可以在没有人工干预的情况下自我导向, 对不可预测环境具有一定的自适应能力, 并且可以在一些设计未预期的场景条件下独立执行任务, 从而能在更广泛的操作环境中提供更多的高水平“自动化”系统功能(van den Broek, Schraagen, te Brake, & van Diggelin, 2017; Kaber, 2018)。

表2 自动化与自主化之间工程心理学特征的比较 (修改自: 许为, 2020)

| 工程心理学特征 | 自动化 | 半自主化(针对特定场景、任务) | 全自主化 |

|---|---|---|---|

| 实例: 一般办公软件, 自动化生产线, 自动化飞机驾驶舱 | 实例: 智能音箱, 智能决策系统, 自动驾驶车(L2及以上) | 实例: 科幻电影《终结者》中的Skynet机器人 | |

| 感应环境的能力 | 比较有限 | 先进的多模态感应 | 更先进的多模态感应 |

| 认知能力(知觉整合、模式识别、学习、推理、决策等) | 没有 | 有部分 | 有 (包括自主设定目标、调整策略、资源分配等) |

| 执行操作的能力 | 人工激活操作, 根据预定不变的规则执行操作 | 人工激活操作, 独立执行操作 | 自主激活操作、独立执行操作等 |

| 对不可预测环境的自适应能力 | 没有 | 有部分 | 有 |

| 系统操作结果 | 具确定性 | 具不确定性 | 具不确定性 |

| 系统运行中对人工操作的需求 | 需要(特别是设计无法预料的操作场景, 非正常、应急状态) | 需要(设计无法预料的操作场景,非正常、应急状态) | 一般不需要(人应是系统最终决策者) |

由表2可知, 自动化和自主化之间的区别不是在自动化水平上递进的关系, 有没有基于智能技术的认知、独立执行、自适应等能力是两者之间本质上的区别。一个智能系统借助于一定的算法、机器学习和大数据训练等手段, 可以在一定的场景中自主地完成以往自动化技术所不能完成的任务(Madni & Madni, 2018; Kaber, 2018)。比如, 基于自主化技术的自动驾驶车, 能够在一个特定园区内, 针对各种交通场景, 独立自主地执行公共交通的输送任务; 基于大数据和机器学习技术的智能医疗诊断系统拥有学习、模式识别、推理等能力, 可以节省大量人工, 高效地提供相当于资深专家水平的诊断服务。自主化技术的这些工程心理学本质特征是考虑针对智能技术的工程心理学解决方案的出发点。

2 智能时代工程心理学的机遇

2.1 智能时代工程心理学的重点研究对象: 新型人机关系

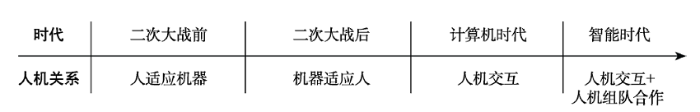

从发展的历史来看, 作为一门年轻的交叉学科, 工程心理学每一次的发展都是受到技术的影响, 特别是学科研究的对象, 即人机系统中的人机关系。特定技术时期的人机关系特征决定了该时期工程心理学研究和应用的重点。如图1所示, 工程心理学研究和应用的重点从二次大战前的基于“人适应机器”的人机关系演变到二次大战后的基于“机器适应于人”的人机关系。进入计算机时代, 人机关系演变为人与机器(即基于非智能计算技术的产品和系统)之间的交互, 即人机交互(human-computer interaction, HCI)。

图1

智能技术赋予人机系统中机器新的角色。在非智能时代(例如计算机时代), 人类操作员作为操作员或监控员, 操作基于计算技术的机器(例如自动化系统), 而机器充当辅助工具。在智能时代, 基于智能技术的机器从一种支持人类操作的辅助工具发展成为一个具有一定认知、独立执行、自适应等能力的自主化智能体(intelligent agent), 并且在一定程度上具备类似于人类的行为能力(Rahwan et al., 2019)。在人机操作环境中, 拥有自主化特征的智能体与人类操作员成为合作队友, 扮演“辅助工具 + 人机合作队友”的双重新角色。由此可见, 智能时代的人机关系已经演变成为一个团队合作的队友关系, 形成一种“人机组队” (Human-Machine Teaming, HMT)式合作(Chen & Barnes, 2014; Brill et al., 2018; Brandt, Lachter, Russell, & Shively, 2018; Shively et al., 2018)。这种新型人机关系正在成为智能时代工程心理学的重点研究对象。

2.2 人机交互与人机组队工程心理学特征的比较

表3概括了非智能系统中人机交互与智能系统中人机组队之间的工程心理学特征。前面表2中智能系统所具备的认知能力等自主化特征决定了这两种人机关系本质上的差别。在非智能系统人机交互中, 非智能系统是作为一种辅助工具(例如, 自动化机器)来支持人类的操作。本质上来说, 基于非智能技术的机器是通过“刺激-反应”式的“交互”来完成对人类操作的支持。机器依赖于由人事先固定设计的逻辑规则和算法来响应操作员的指令, 通过单向、非分享的(即只有人针对机器单方向的信任、情境意识、决策控制等)、非智能互补(即只有人类的生物智能)等方式来实现人机交互。尽管人机之间也存在一定程度上的人机合作, 但是作为辅助工具的机器是被动的, 只有人可以启动这种有限的合作。

表3 人机交互与人机组队之间工程心理学特征的比较

| 工程心理学特征 | 人机交互 | 人机组队 |

|---|---|---|

| 主动性 | 只有人主动地启动任务、行动, 机器被动接受 | 人机双方均可主动地启动任务和行动 |

| 方向性 | 只有人对机器的单向信任、情景意识、决策 | 人机双向的信任、情景意识、意图, 分享的决策控制权(人应拥有最终控制权) |

| 互补性 | 人与机之间无智能互补 | 机器智能(模式识别、推理等能力)与人的生物智能(人的信息加工等能力)之间的互补, 优化智能系统设计 |

| 预测性 | 只有人类操作员拥有这些特征 | 人机双方借助行为、情景意识等模型, 预测对方行为、环境和系统的状态 |

| 自适应性 | 只有人类操作员拥有这些特征 | 人机双向适应对方以及操作场景的行为 |

| 目标性 | 只有人类操作员拥有这些特征 | 人机双向均可设置或调整目标 |

| 替换性 | 机器借助于自动化等技术主要替换人的体力任务 | 机器可以替换人的认知、体力任务(人机双向可主动或被动地接管、委派任务) |

| 合作性 | 有限的人机合作 | 更大范围的人机合作 |

人机组队式合作应该是一种更加高效的人机合作, 但是目前还没有这方面的系统研究, 有待于今后工程心理学研究的验证。我们认为人机组队式合作可能拥有“双刃剑”效应。例如, 一方面, 智能系统利用大数据、AI深度学习等技术可以整合来自大量专家知识的智慧, 主动地帮助人类操作员在非正常的场景中解决以往单人的知识或者操作所不能解决的问题。这是一般人机交互式合作无法达到的; 另一方面, 如果智能系统设计中不遵循“以人为中心的AI”理念, 不保证人类拥有系统的最终决策控制权, 智能系统自主独立执行的结果有可能带来伦理道德、安全等隐患。

2.3 智能系统工程心理学核心问题的概念空间

在实现全自主化技术之前, 目前的智能系统同时拥有非智能技术(基于计算技术的自动化等)和智能自主化技术。人与智能系统交互的操作作业主要包括: (1)由智能自主化特征决定的新型人机关系——人机组队合作; (2)人机交互(包括人与智能系统中非智能技术部分的交互、发生在智能系统人机界面上的人机交互等)。所有这些交互都需要人工操作(包括应急状态下的人工干预) (见表2)。例如, 自动驾驶车的机载系统同时采用了自动化和智能自主化技术。自动驾驶技术等级越高(L2以上), 机载系统中自主化的程度就越高。目前民用飞机驾驶舱的自动飞行系统不含有自主化技术。随着智能技术的应用, 自动化和自主化技术有可能在未来的智能化驾驶舱中共存。

为了有效地定义和分析工程心理学核心问题的空间, 许为(2020)提出了一个自主化、自动化、人工操作三者关系的三维空间概念模型(见图2)。如表2所指出, 自动化是完全不具有基于机器智能的认知等能力, 而自主化拥有基于机器智能的认知等能力, 因此我们可以假设自动化与自主化之间是正交的关系。在实现全自主化技术之前, 人工操作(特别是在应急状态下的人工干预)是人机系统安全的重要保证。人工操作与自主化和自动化程度之间分别存在着一对一的关系(见图2中的平面AOC、平面AOB): 即随着自主化和自动化程度的提高, 人工操作的需求随之减少。可见, 人工操作是以上两个二维平面(自主化 × 人工操作, 自动化 × 人工操作)所共有的一个维度。因此, 自主化、自动化、人工操作三个变量可以整合用来表征三者之间的一个三维空间关系。可以说, 该三维空间表征了人与智能系统交互中工程心理学核心问题的空间概念。

图2

从图2所表征的三维概念空间中可知: (1)如上面所分析, 在人与智能系统(拥有自主化特征的智能体)交互中会产生人机组队式的合作。(2)在实现全自主化之前, 任何智能系统都拥有一定程度上的自动化功能, 人对智能系统的操作必然包括人-自动化交互。这意味着在使用智能系统中人类操作员可能遇到与人-自动化交互研究中所发现的类似工程心理学问题, 而以往基于自动化的人机交互研究成果将有助于解决基于自主化的人机交互中的一些工程心理学问题。(3)人机组队合作、基于自动化以及基于自主化的人机交互都需要人工操作, 智能系统必须提供有效的人机交互。因此, 该三维概念空间模型也表征了智能时代工程心理学研究和应用的重点: 人机组队和人机交互。

2.4 智能时代工程心理学的学科理念: 以人为中心的AI

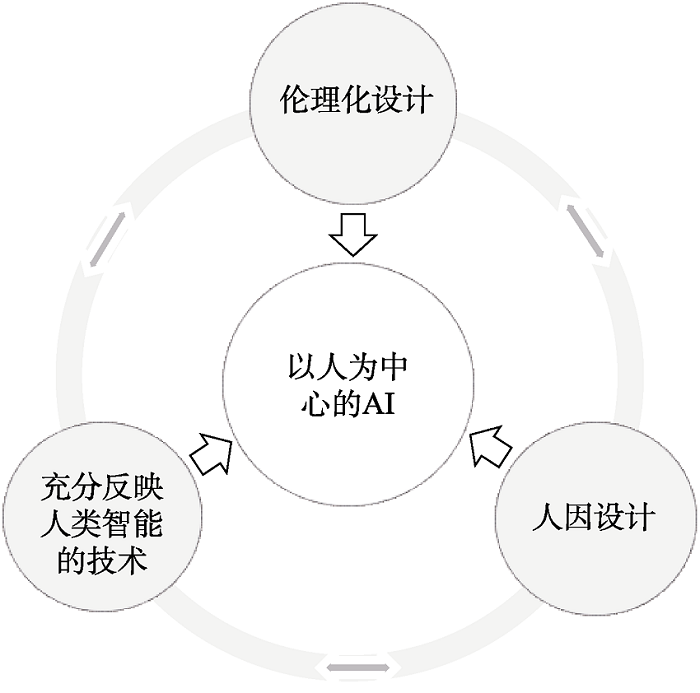

针对基于AI技术的智能系统可能带来的伦理道德方面的负面影响, 斯坦福大学、加州大学伯克利分校、MIT等大学分别成立了“以人为中心的AI (Human-Centered AI, HAI)”的研究机构。这些HAI的研究策略强调智能系统开发中两方面的工作: 技术与伦理化设计。强调开发智能系统AI的下一个前沿不能仅仅是技术, 它也必须合乎道德伦理的和惠及人类的; AI是增强人类的能力而不是取代人(Li & Etchemendy, 2018)。从社会技术系统的大环境中考察HAI, 针对智能系统的研发, 许为(2019b)提出了一个扩展的HAI概念模型(见图3)。该模型包括三个方面: (1)人因设计: 强调从工程心理学的学科理念(人的因素)出发, 智能系统的研发要充分符合人的各种需求, 为人类提供安全的、高效的、健康的、满意的基于智能技术的工作和生活; (2)伦理化设计: 从人类伦理、道德等角度出发, 智能系统应该致力于解决人类社会的偏见、维护人类公平和公正等问题; (3) 充分反映人类智能的技术: 进一步提升AI技术以达到反映以人类智能为特征的深度(更像人类的智能)。

图3

HAI中的“人因设计”强调在智能系统研发中注重对智能时代新型人机关系中人-智能体交互的优化设计, 不是片面地注重AI单方面。同时, 强调要充分考虑人的因素和环境因素对人-智能体交互的影响。基于两个时代人机关系之间在工程心理学特征方面本质上的差别(表2~表3), 与计算机时代人机交互所受的影响因素相比, 智能系统的“人因设计”需要考虑更多的人和环境方面的因素, 比如, 人的情绪、情感、人格、文化、社会等因素(例如, Santamaria & Nathan-Roberts, 2017)。这方面有待于工程心理学的进一步研究。本文也将在“智能时代工程心理学的应用”部分中, 对相关的内容做进一步讨论。

对于“伦理化设计”, AI专业人员通常缺乏将伦理道德方面的考虑应用于工程设计的正式培训, AI界现在已经认识到需要与社会和行为等学科的合作(Donahoe, 2018)。工程心理学可从社会技术系统的宏观角度(即宏观工效学)出发, 从文化、心理、组织、社会等角度, 采用行为科学的方法来研究“AI伦理化设计”的相关问题, 比如, AI公平和公正性、人的决策权、人机协作策略、员工技能成长等各种问题。

针对“充分反映人类智能的技术”, 这方面的工作主要依靠计算机、AI技术等领域, 同时也需要与认知、神经科学等学科的合作。其中, 工程心理学通过与AI界的合作, 可以为算法建模, 训练和测试等做出贡献。例如, 研究人类智能的理论模型(人类信息加工的方式和策略、人类知识的表证和结构等), 加速将心理学理论应用在AI的建模和算法中。另外, 提倡以人为中心的机器学习(ML)方法, 在基于ML的智能系统的数据建模、训练、测试中, 与AI人员合作, 定义预期的用户体验目标, 帮助优化ML的训练数据和算法, 避免极端的算法偏差(Koene, Dowthwaite, & Seth, 2018)。

HAI既继承了工程心理学的基本科学理念, 同时又充分考虑了智能时代技术的特征。所以, HAI就是智能时代提升了的工程心理学学科理念。在智能系统工程心理学核心问题的概念空间中(图2), HAI就是在智能系统研发中寻找工程心理学解决方案过程中所应该遵循的理念。

3 智能时代工程心理学的研究重点

3.1 智能时代的新型人机关系

人机系统是工程心理学研究和应用的对象。作为智能时代的新型人机关系, 目前针对人机组队(HMT)的工程心理学研究开始在一些领域中展开。例如, 空中智能交通管理系统中的空管员-空管自主化系统组队(Kistan, Gardi, & Sabatini, 2018), 特殊环境中的操作员-智能机器人组队(Calhoun, Ruff, Behymer, & Frost, 2018), 智能驾驶舱中飞行员-机载自主化系统组队(Brandt, Lachter, Russell, & Shively, 2018), 未来高等级自动驾驶车中的驾驶员-车载自主化系统组队(de Visser, Pak, & Shaw, 2018; Navarro, 2018)。当前的研究主要集中在工程心理学的一些基本问题上, 包括研究的理论框架、人机合作特征、情景意识、人机互信、人机决策控制等方面。

3.1.1 研究的理论框架和基本问题

理论框架。研究者采用了以往成熟的人-人团队理论(Madhavan & Wiegmann, 2007; de Visser et al., 2018), 例如, 根据人-人理论, 研究者制定了人机组队合作中人-智能体两个合作伙伴之间的一些基本工作原则: 双向的(沟通、信任等)、共享的(目标、情境意识、语言、意图、决策、自主化控制等)、协商的责任以及可控的工作负荷等(Madni & Madni, 2018; Shively et al., 2018; Ho et al., 2017)。也有研究提出要采用协同认知系统(Hollnagel & Woods, 2005)、弹性工程学(Woods et al., 2012)等理论框架。例如, 根据协同认知系统理论, 如何利用人类的生物智能和机器智能在不同程度上的深度整合以及互补来支持基于人机组队合作的自主化系统设计。

基本问题。HMT的工程心理学研究需要与AI、计算科学等领域的跨学科合作(McNeese, Demir, Chiou, & Cooke, 2019), 但是许多基本问题需要工程心理学的答案。例如, 如何更好地理解人机交互(HCI)与人机组队(HMT)的区别; 人机交互与HMT之间在人机合作上的本质差别(见表3); HMT对现有人机系统理论的影响; 针对智能时代的人机合作, 研究者提出了不同的概念, 包括人机整合(integration)、人机融合(fusion)、人机共生(symposia)等, 它们与HMT的关系是什么, 是否各自表征了新型人机合作关系中合作的不同层次或程度; HMT中人机合作的优化组合受哪些因素影响; 自主化程度对HMT团队绩效的影响; 人类操作员的心理因素(情绪、情感、人格等)对HMT团队绩效的影响, 等等。总之, 针对智能时代新型人机关系的工程心理学研究处于初期阶段, 有待今后的深入开展。本文以下主要就人机组队中的心理结构和决策控制两方面的问题进行综述和分析。

3.1.2 人机组队中的心理结构

心理结构(mental construct)包括心理模型、情景意识(situation awareness, SA)、信任。在HMT研究中, 工程心理学对人机组队合作中双向的人机SA分享、人机信任、心理模型感兴趣, 它们直接影响HMT的绩效。

人机情景意识分享。以往关于SA的研究通常是针对非智能系统操作中的单向式个体SA以及基于人-人团队理论的团队式SA, 这些结果不一定完全适用于HMT中的人机双向SA。团队式SA还包括共享式和分布式SA (Stanton, 2016)。Kitchin和Baber (2016)的初步研究表明分布式SA在团队合作中的绩效高于共享式SA, 这是因为分布式SA注重人、智能体各自所需的操作情境和信息。另外, 目前还缺少针对HMT、操作性强的SA模型和测试方法(Stanton, Salmon, Walker, Salas, & Hancock, 2017; 石玉生, 黄伟芬, 田志强, 2017)。在应用中, 智能体通过传感器和计算模型得到针对人的行为评估、系统以及环境的SA, 该SA可能与操作员所获取的SA不同, 因此操作员与智能体之间的SA模型需要有效的双向沟通(Madni & Madni, 2018)。例如, 高等级自动驾驶车中的驾驶员与自主驾驶系统共享的SA信息(Endsley, 2017)。在未来单人操纵的智能化大型民用飞机驾驶舱中, 当飞行员失能时, 智能机器副驾驶通过SA模型迅速查询到飞行员的状态, 迅速有效地掌控飞机操控权(Vu et al., 2018)。工程心理学应该丰富HMT的SA理论, 并且为人机的情境模型定义认知架构和评价方法。

人机互信。人机互信直接影响HMT的团队绩效。例如, 在未来空中智能交通指挥系统中, 空管员与自主系统之间维持适当的信任有助于人机之间的协调(Kistan et al., 2018)。对于基于自主化技术的自动驾驶车, 如果处于自动驾驶模式中的驾驶员双手离开方向盘, 智能体可认为当前的驾驶员是不可信任的, 从而启动某种告警方式将驾驶员拉回信任状态。目前的机器智能体还缺乏类似人类的“思考” (价值观等), 无法解释其推理决策过程(许为, 2019b; Mercado et al., 2016), 这对HMT信任研究的应用带来了困难。其中, 信任修复在现有的人-自动化交互和人-人信任模型中并没有得到充分的研究。Chen等人(2017)提出的代理透明度模型(SAT)可用作为校准团队信任的一个有效工具。de Visser等人(2018)认为发生错误后积极开展信任修复应该是HMT设计的基本要求, 并提出了一些策略。今后的研究需要进一步开展信任测量、建模、修复、信任违规以及校正(Kistan et al., 2018; Baker, Phillips, Ullman, & Keebler, 2018), 并且如何确定和量化不同操作场景中人机之间动态化功能交换时所需的信任。

心理模型共享。对人-智能机器人之间共享的心理构造研究也是目前研究的重点之一。智能机器人已经可以被赋予一些特殊的能力(比如社交), 有可能构建具备理解人意图的“心理模型” (Prada & Paiva, 2014; Chen & Barnes, 2014), 有助于成为人类的合作同伴。基于人-人团队合作的研究, Scheutz, DeLoach和Adams (2017)初步提出了建立人机合作中共享心理模型的一个认知计算框架。Kaur, Williams和Lasecki (2019)则提出了在复杂领域(例如医疗保健, 自动驾驶)中人机之间建立共享心理模型的基本方法。Ramaraj, Sahay, Kumar, Lasecki和Laird (2019)通过实验研究了影响用户构建机器人心理模型的因素, 结果证实用户界面透明度可以有效提高建立这种心理模型的准确性。目前还缺乏针对人-机器人组队中心理模型与社会、情感交互之间关系等方面的工程心理学深入研究。

3.1.3 人机组队中的决策控制

在传统人机交互中, 基于计算技术的机器是作为一个决策支持工具服务于人, 而HMT强调人与智能体对系统决策控制的共享(van den Bosch & Bronkhorst, 2018)。有效的HMT应该允许在任务、功能、系统各个层面上实现决策控制权在人与智能体之间的分享。决策控制权的转移取决于双方的信任、共享SA、合作关系等因素。例如, 在自动驾驶车领域, 美国MIT的自主车研究项目提出了以人为中心的共享自主化研发范式(Fridman, 2018), 其人机合作包括分享的SA、信任支持、风险评估等, 保证车辆控制权在人机之间的有效过渡, 驾驶员拥有最终控制权。Muslim和Itoh (2019)遵循以人为中心的理念提出由自适应控制来共享自动驾驶车控制权的方法以及人机之间控制权限切换的策略。该策略保证人类操作员拥有对系统的最终权限, 从原理上提出了如何以及何时可以在人机之间转换控制的建议。

针对系统的最终决策控制权问题, “以人为中心的AI”设计理念模型强调, AI是增强人类的能力而不是取代人, 人应该是智能系统的最终决策控制者(许为, 2019b)。在HMT中, 这种人机之间最终操控权的分配转移应该是建立在双向SA和信任、分享的任务和意图等合作的基础上所产生的操控权分享。针对近几年发生的多起自动驾驶车致命事故的调查结果表明, 司机对智能技术的过度信任、操作中的低参与度、低效的人机交互和告警设计等原因导致司机未能在应急状态下快速接管驾驶(NTSB, 2017; Hancock, 2019)。工程心理学的解决方案就是要充分考虑人-机载智能系统交互中人机组队合作的设计策略(尤其对高等级自动驾驶车), 通过有效的人机交互设计(自然、多模态协同式用户界面等)在应急状态下提供快速有效的人机控制权转移。

今后的工程心理学研究需要了解智能体在什么条件下以及如何接管或者将功能切换到人类操作员。例如, 空管员与未来智能交通管制系统之间可否依据人机互信度来执行有效的控制切换(Kistan et al., 2018)。Madni和Madni (2018)提出了一个用于航空领域的自适应HMT架构, 他们认为自适应的HMT需要基于协同的人机绩效、SA共享、人机知识共享、动态任务分配, 从而达到人机决策共享的目的。人机组队中的决策控制方面的工作有待于工程心理学研究的开展。

3.2 智能时代的人机交互

3.2.1 人机交互的界面范式和模型

人与智能系统交互的新需求。智能时代涌现出丰富的用户需求和应用场景(许为, 2017), 人与智能系统的交互需要有效的人机界面范式(paradigm)和模型。在实现多模态、虚拟现实、普适计算等技术中, 硬件技术已经不是障碍, 但是用户的人机交互能力并没有得到相应的提高。类似于人-人之间的多模态并行的自然式交互, 如何设计有效的视、听、触、手势等多模态的融合以及并行的交互范式是智能时代人机交互研究的重要内容。历史上界面范式和模型引导着人机交互的发展, 例如WIMP (window, icon, menu, pointing)范式促使图形用户界面的诞生, 促进了PC时代的繁荣。但是WIMP有限的感知通道、不平衡的输入/输出带宽等问题制约了人机交互的发展(范俊君, 田丰, 杜一, 刘正捷, 戴国忠, 2018)。已有研究提出了Post-WIMP和Non-WIMP的概念, 包括针对笔交互场景的PIBG范式(physical object, icon, button, gesture), 面向普适计算交互场景的实物用户界面(tangible user interface, TUI), 基于现实的交互(reality-based interaction, RBI)等, 但是有效性还有待于进一步验证(参见综述, 范俊君等, 2018)。

今后的工作。范俊君等人(2018)提出了一个人机交互的软件研究框架。该框架由多个人机交互的核心研究内容组成, 包括界面范式、交互设计原则、心理学模型等。他们建议需要通过心理学模型研究来构建用户模型, 形成界面评估准则, 并且对界面软件的评估有着指导性的意义。张小龙、吕菲和程时伟(2018)则从信息载体、交互对象和方式等方面来分析目前智能系统的界面设计, 提出了一个针对智能系统的功能角色、交互模态、交互命令、信息呈现方式的RMCP (role, modal, commands, presentation style)界面范式。智能系统人机界面范式和模型的研究涉及多个领域, 国内的研究主要是在计算技术界开展。工程心理学应该为定义界面范式和隐喻、实验验证等方面提供学科支持。

3.2.2 人机交互的工程心理学计算建模

人机交互和合作的认知模型。基于人类处理器模型的MHP (the model human processor)和GOMS (goals, operators, methods, selections rules)等简单的工程心理学模型已经不能满足当前复杂的交互场景和任务(Card, Moran, & Newell, 1983)。工程心理学需要建构智能时代符合新型人机合作关系的认知和计算模型, 从而指导智能系统的人机交互设计(刘烨, 汪亚珉, 卞玉龙, 任磊, 禤宇明, 2018)。虽然“感知-记忆-判断” (PMJ)模型在工程心理学等领域得到了一定的应用, 但是该模型并没有涉及到复杂的人机交互机制(Fu et al., 2014)。刘烨等(2018)初步提出了一个面向智能时代的人机合作心理模型。尽管该模型仍存在一定的局限(例如, 不是一个细化的、可计算的模型, 尚未开展人机交互实验验证), 但是该模型考虑了机器智能、人机交互复杂性等因素, 部份地融合了多模态并行、分布式认知的思路。同时, 国内计算技术界研究者提出了一些阻碍智能时代人机交互发展的理论和技术问题, 包括认知模型、分布式认知理论、基于场景上下文的知识表征、人机交互的认知计算模型等(范俊君 等, 2018)。社会交互和情感交互的认知建模也是目前智能系统研发中面临的重要问题。工程心理学应该在这些方面有所作为。

人类绩效模型。以往的工程心理学研究已提出许多人类绩效模型(human performance model, HPM)模型(例如, ACT-R、MIDAS) (Foyle & Hooey, 2007)。智能时代的HPM在系统设计中, 应该不但可以通过预测人类绩效来节省运行实验的时间和成本, 而且还可以作为输入直接集成到智能系统中, 帮助提高系统安全和绩效(Wu, 2018)。例如, 实验表明当任务的上下文和操作员信息处理能力发生变化时, 嵌入智能系统的HPM可以直接预测和优化人的绩效(Zhao & Wu, 2013)。Salvucci (2006)的研究表明, HPM可以在实际超速发生几秒钟之前预测驾驶员的超速行为, 从而向驾驶员发送警告。利用驾驶员的车道变更模型可以预测驾驶员何时变道, 并发出警告。因此, HPM在预测人的绩效方面能够为智能系统的研发发挥 作用。

人机界面的解释计算模型。由AI的“黑匣子”(black box)效应所导致的AI透明性、解释性等问题, 直接影响用户对智能系统的信任度和决策效率(许为, 2019b)。目前针对可解释AI的研究思路之一是采用现有的心理学解释理论来帮助开发新的解释计算模型(Gunning, 2017)。心理学家已经开展了许多针对解释概念、理论、表征、机制、测量、建模等方面的研究, 包括诱导性推理、因果推理、自我解释、对比解释、反事实推理等(Lombrozo, 2012; Hoffman et al., 2017)。尽管这些理论假设在心理学实验室中已得到验证, 但是目前存在心理学理论向实际应用转换的鸿沟。工程心理学应该帮助促成这种转换, 构建有效的计算模型来表证可解释的结果, 开发有效的解释用户界面, 并且预测和评估其有效性。

3.2.3 人机交互设计的工程心理学问题

新型人机界面。智能技术催生了一系列新的人机交互技术以及相应的新型人机界面。这些新型人机界面包括自然用户界面(例如, 语音、视线、手势、触觉等交互)、脑机界面、可穿戴设备交互、隐式交互界面、多模态交互界面等。工程心理学已经开展了初步的研究(葛列众, 许为, 2020), 但是远没有满足智能系统人机界面设计中的实际需求。比如语音用户界面、虚拟现实中人机界面中的工程心理学问题(百度, 2019)。工程心理学需要为智能系统的人机界面设计提供基于实验验证数据的学科支持, 进一步提高新型人机交互的自然性、精确性和有效性。

新型应用场景。智能技术在智能物联网、普适计算、智能环境等新型落地场景中的应用将产生一系列新的工程心理学问题。例如, 人类有限的认知资源是普适计算中人机交互的瓶颈。早在2002年, 卡内基大学的Aura研究项目就指出普适计算中最珍贵的资源不是计算机技术, 而是人的认知资源(Garlan et al., 2002)。在普适计算时代智能系统主动启动的隐式人机交互场景中, 用户当前的任务可能与智能系统启动的交互任务产生不同模态之间认知资源的竞争, 用户面临认知负荷、注意资源分配、多模态之间竞争等一系列工程心理学问题(王巍, 黄晓丹, 赵继军, 申艳光, 2014; 岳玮宁, 董士海, 王悦, 汪国平, 王衡, 陈文广, 2002)。有研究提出为了降低用户的认知负担, 可以在显式交互模式基础上融入隐式交互的模式, 从而降低用户的认知负担; 或者从用户认知特征入手, 通过适当的交互技术, 使交互方式适应用户的认知特征, 从而达到最佳的注意资源分配和工作效率(王巍 等, 2014)。这些问题都有待于工程心理学研究的贡献。

3.2.4 人机交互设计的标准和原则

工程心理学的重要任务之一是通过实验和应用验证提出一系列针对技术的设计原则以及设计标准, 从而为人机系统的优化设计发挥重要作用。以往众多的工程心理学设计原则和标准基本上是针对非智能系统开发的。为智能系统研发和应用服务, 工程心理学责无旁贷。

设计标准。目前还缺乏具体系统化的针对智能系统的人机交互等设计标准。国际电气工程师学会(IEEE)现有的AI设计指南主要是从道德伦理等角度来提供指导(IEEE, 2019)。国际标准化组织(ISO)也看到了这种紧迫性。本文作者之一许为所参与的国际标准化组织(ISO)人-系统交互技术标准专家组(ISO TC 159/SC4/WG6)正在起草一份智能系统中所存在的人因学问题的技术文件(ISO, 2019)。该文件将为ISO确定今后开发这方面的国际标准提供依据。针对工业界的需求, 美国人因和工效学会(HFES)就自动驾驶车的人机交互设计临时提出了一些设计原则(HFES, 2018)。

设计原则。工程心理学需要为AI设计师和设计决策提供具体、可操作的设计原则。例如, 微软AI研究人员与人因学专家联手从150多个与AI相关的设计建议中提取了一系列指南, 并通过三轮相关产品的评估验证, 从交互初始阶段、用户与系统交互过程中、系统出错情况下、随着时间推移智能系统应该如何表现等4个方面, 提出了18条设计准则和指南(Amershi et al., 2019)。许为(2020)对智能系统研发也提出了8项基本设计原则(葛列众, 许为, 2020)。许多AI研发企业也在智能系统的研发中, 开展相关的工程心理学研究, 并将这些研究成果直接应用在智能系统研发中(例如, 百度, 2019)。

4 智能时代工程心理学的应用

4.1 从人机交互到人-AI交互

作为一门应用学科, 工程心理学必须为社会急需解决的问题提供方案。进入智能时代, 人们在使用智能系统中与带有自主化特征的智能体之间产生交互。类似于计算机时代带来了人机交互的应用领域, 目前一个人-AI交互的新应用领域正在逐渐形成。与计算机时代人机交互的应用范围比较, 人-AI交互的应用范围更加广阔。

在人机关系方面, 从人机交互式扩展成包括人机组队在内的新型人机关系; 在交互层面, 除了人机交互以外, 还有社会、情感交互等(例如, 智能机器人); 在交互界面方面, 自然的、隐式的、多模态的人机交互技术日新月异; 在交互场景方面, 无所不在的普适计算应用场景, 虚拟现实或者虚实混合的场景正在形成; 在交互行为方面, 除了传统的人类启动的人机交互, 智能体可以依据用户认知或行为状态、上下文等信息主动启动隐式的人机交互(例如, 环境智能); 在交互复杂性方面, 人可与多个子系统中的智能体同时发生交互, 各个智能体之间也有彼此的交互, 而上述这些交互最终会影响人与整个智能系统的交互(ISO, 2019)。

在用户方面, 智能时代的用户需求更加丰富、多层次化, 包括生理、认知、情感、安全、个人隐私、伦理道德、技能成长、自主决策权等; 在用户群体方面, 智能技术正在向残疾人、老年人、医疗康复等特殊群体推广(智能医疗等); 对人的影响方面, 智能系统对用户的生理、认知、情感、人格、行为和动机产生影响(例如, Santamaria & Nathan-Roberts, 2017), 智能系统可能会影响人类执行任务的学习动机、技能和能力等; 在用户应用场景方面, 智能技术除了改变人们的工作环境, 也正在向更广阔的领域推广(例如, 医疗、康复、娱乐、家居服务) (许为, 葛列众, 2018)。

在社会组织方面, 在一定的社会文化环境中运行的智能系统会带来挑战。例如, 未来一个庞大的智能系统(智能城市等)可由许多智能体(子系统)组成。来自不同供应商的子系统之间可能存在文化和立法规则(个人隐私, 伦理等)等因素带来的兼容性问题。因此, 各子系统智能体之间的有效交互可能需要人类用户的协调或充当不兼容系统之间的桥梁(ISO, 2019)。另外, 智能系统(智能制造等)还可能带来对组织决策、人机协作策略、组织建设、工作和生产规划等方面的影响(Jarrahi, 2018)。

由此可见, 人-AI交互中有许多的工程心理学问题亟待解决。与人机交互相比, 人-AI交互扩大了工程心理学的应用范围。相应地, 借助于“以人为中心的AI”设计理念, 工程心理学的应用和实践需要从更广阔的社会技术系统大环境的视野开展, 包括生理、心理、工程、技术、社会、伦理道德、文化、组织等各个方面。

4.2 挑战与建议

尽管智能技术开拓了工程心理学的应用范围, 但是目前工程心理学对智能系统研发的参与和影响力遇到了挑战。基于AI等技术的自动驾驶车的研发就是一个典型例子。目前许多企业投入了大量 资金来研发自动驾驶车。然而, 近几年智能自动驾驶汽车已经导致了多起致命事故(NTSB, 2017; Endsley, 2018)。CARAVAN (2018) 的民意调查表明, 在受调查的美国司机中, 64%的司机表示不愿意与自动驾驶车分享道路。另外, AI产业界已经认识到目前AI和智能系统的开发遇到了两方面的瓶颈效应: AI技术与AI应用方案的用户体验落地场景(李彦宏, 2017)。智能系统输出结果的“黑匣子”现象还会导致用户对智能系统的决策产生疑问, 直接影响用户的信任度和决策效率(Bathaee, 2018)。

历史似乎在重复。上世纪80年代个人电脑刚兴起时, 设计中不考虑普通用户的体验。随着计算机的普及, 用户体验的问题逐渐暴露出来。在工程心理学等学科的参与和推动下, 产生了用户体验/人机交互的应用领域(许为, 2003b)。类似的事情目前正在发生, 当前智能系统的研发主要由以技术为中心的理念来推动。资深人因学家Hancock (2019)将当前的智能自主化技术(自动驾驶车)研发热潮形容为“就像一匹马已离开马厩”, 而Salmon (2019)认为“(人因学)再次发现自己处在一个相似的境地: 追逐一匹已经真正开始狂奔的马”。如同30年前“以用户为中心设计”实践的兴起, 今天, 承担智能时代新版本“以人为中心的AI”的实践再一次历史性地落在了工程心理学等学科的肩上。虽然工程心理学的理念在初期可能不被AI界完全接受, 但是, 我们要最大程度地减小这种滞后效应。正如当年对用户体验/人机交互领域的不断参与和输送心理学等专业人才, 工程心理学在智能时代的影响力最终取决于我们持之以恒的努力。

针对工程心理学新发展所面临的挑战, 许为和葛列众(2018)提出了一系列建议: 建立完善的人因学科(包括工程心理学、人因学、用户体验等)高校教育体系; 建立完善的产学研相结合的以交叉学科为基础的人因学科科研体系; 建立人因学科行业资质标准和设计标准体系; 倡导人因学科引领的设计和创新、提升人因学科理论、优先在重要领域开展人因学科的应用(智能系统、用户体验、航天航空和医疗健康等)。针对智能时代工程心理学应用所面临的挑战, 本文进一步提出以下一些具体建议。

首先, 为社会培养跨学科的专业人才。过去的十多年, 心理学等学科为社会输送了大量从事用户体验、人机交互的人才。同时, 高科技合资企业传承国外总公司的企业文化。这两股力量汇集其他因素逐渐地改变了传统企业的文化, 逐步带来了今天整个社会对用户体验的广泛共识(许为, 2005)。目前, 国外许多知名高科技企业基本上都已经建立起“伦理化AI”的理念, 分别制定了AI技术开发的伦理规范。尽管不完善, 但是正在走向“以人为中心AI”的理念目标。因此, 我们要为将来全社会对“以人为中心AI”理念达到共识的目标培养和输送跨学科人才。具体地, 需要在学位和课程设计上为学生提供学习跨学科知识的机会, 包括为心理学专业学生提供AI副修或课程、为AI专业提供心理学副修或课程等, 并建立工程心理学与AI交叉学科型应用硕士、博士学位。清华大学心理学系最近与校内工程学科类系合作设立的定位于“应用心理学 + 智能时代创新”硕士项目就是一个很好的实践。

其次, 主动宣传学科理念和影响AI等领域。针对学科影响力的挑战, 美国人因学会(HFES) 前任主席William Howell早在2001年就提出了“分享理念”的模型: 即与工业设计、计算机等学科共享“以人为中心设计”的学科理念(Howell, 2001), 而不是“封闭独享”的模型。过去的20年, 心理学等行为科学融入人机交互、用户体验领域的发展正是这种模型的体现。在智能时代初期, 更需要工程心理学专业人员积极主动与AI界分享理念。例如, 许为在国际计算机学会(ACM)期刊上发表的关于“以人为中心的AI”理念的一文(Xu, 2019), 已开始被美国加拿大几所高校的计算机系教授列为AI课程的必读文章。由本文作者共同主编的《用户体验: 理论与实践》教材书包括了智能系统设计、创新设计的内容(葛列众, 许为, 2020)。在我们正在修订的《工程心理学》教材书(葛列众, 李宏汀, 王笃明, 2012)中也将增加人- AI交互、智能系统设计等内容。

再则, 加强智能时代工程心理学的理论建设, 提升工程心理学学科自身的发展。智能时代的工程心理学要积极开展针对智能系统的学科理论(新型人机关系等)的建设, 明确智能时代工程心理学的学科理念和应用范围, 为智能系统研发设计提供有效的工程心理学方法。

最后, 积极开展工程心理学的应用研究, 提倡跨行业与跨学科的合作。今年初, 国家科技部和教育部联合发文鼓励科研人员从事与当前社会急需问题相关的应用研究, 而且今后职称评定和项目评审的评价系统也将向这方面倾斜。这些措施将有助于鼓励工程心理学人才队伍培养和应用研究的开展。工程心理学教师要积极参与(与其他专业合作)申请国家智能技术相关的研究项目, 主动与高科技企业衔接开展应用研究, 积极争取建立高科技企业冠名的联合实验室或者研究中心, 继续开展校园内跨学科之间的合作。

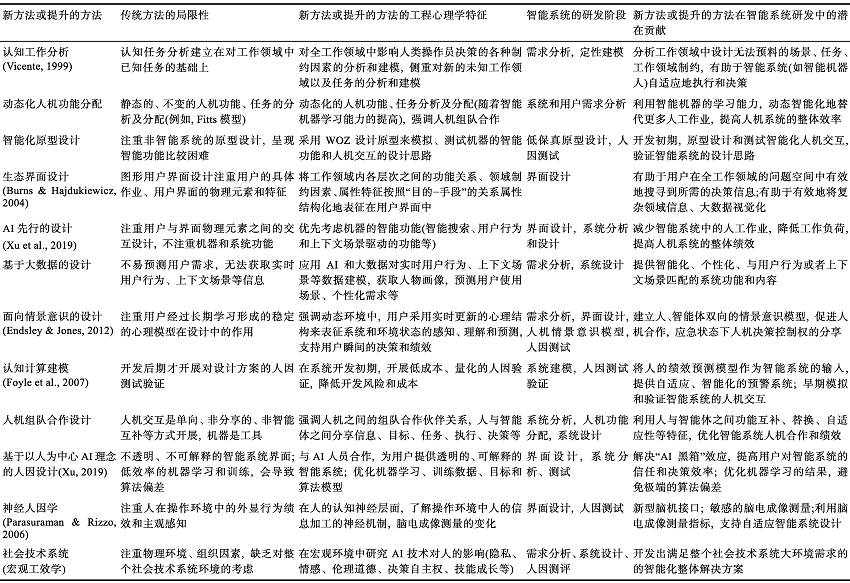

5 智能时代工程心理学的方法

智能时代工程心理学的研究和应用必然对方法论提出新要求。现有的工程心理学方法大多是针对传统非智能系统的研究和应用。从表1~3以及以上讨论中可知, 智能系统与非智能系统之间在许多特征上都有很大的差别, 包括人类操作员(受技术的影响)、机器、人机关系、操作环境等方面。例如, 智能系统所面临的操作环境可能是复杂、瞬间变化、不可预测的场景, 研发需要考虑系统的自适应性和人机分享的情景意识; 智能体的能力随着自身不断的学习而成长, 需要考虑对系统功能的动态优化和利用; 人机组队合作有助于人机决策和控制权的动态分享; 实时在线的数据环境有助于为智能系统获取上下文场景数据; 人类操作员受智能技术多方面的影响, 研发智能系统不仅仅要深入到人类认知神经层面的深度, 也要在广度上拓宽到社会技术系统的宏观环境。

6 小结和展望

(1)当前智能技术表现出的“技术提升 + 应用 + 以人为中心”的时代特征与工程心理学的学科理念不谋而合, 智能技术的发展为工程心理学的研究和应用提供了新的机遇。拥有一定程度的认知、独立执行、自适应等能力是智能自主化技术的工程心理学本质特征, 这些特征是考虑针对智能技术的工程心理学解决方案的出发点。

(2)自主化技术赋予了智能化机器在人机系统操作中新的角色。智能时代的人机关系演变成一种人机组队式合作的新型人机关系。本文提出了一个表征智能系统工程心理学核心问题的空间概念模型, 并且提出了智能时代工程心理学的学科理念: “以人为中心的AI”。

(3)智能时代工程心理学的研究重点包括, 新型的人机关系(理论框架和基本问题、人机合作特征、心理结构以及人机决策控制), 智能时代的人机交互(界面范式和模型、工程心理学计算建模、人机交互设计中的工程心理学问题、标准和原则)等。

(4)人-AI交互拓宽了智能时代工程心理学的应用范围。工程心理学方法需要与时俱进。本文概括总结了一些具代表性的工程心理学新方法或者提升的方法, 分析了这些方法在智能系统研发中的应用和潜在的贡献。

(5)工程心理学在当前智能系统研发中的参与和影响力是远远不够的。针对工程心理学新发展所面临的挑战, 许为和葛列众(2018)提出了一系列建议。针对智能时代工程心理学所面临的挑战, 本文进一步提出以下4项具体的建议: 为社会培养跨学科专业人才; 主动宣传学科理念和影响AI等领域; 加强智能时代工程心理学的理论建设, 提升工程心理学学科自身的发展; 积极开展工程心理学的应用研究, 提倡跨行业与跨学科的合作。

参考文献

Guidelines for human-AI interaction

Ironies of automation

DOI:10.1016/0005-1098(83)90046-8 URL [本文引用: 1]

Toward an understanding of trust repair in human- robot interaction: Current research and future directions

The artificial intelligence black box and the failure of intent and causation

A human-autonomy teaming approach for a flight-following task

In C. Baldwin (ed.),

Human-autonomy teaming interface design considerations for multi-unmanned vehicle control

DOI:10.1080/1463922X.2017.1315751 URL [本文引用: 1]

Human-agent teaming for multirobot control: A review of human factors issues. IEEE Transactions on

Situation awareness- based agent transparency and human-autonomy teaming effectiveness

From automation to autonomy: The importance of trust repair in human- machine interaction,

Human centered AI: Building trust, democracy and human rights by design. An overview of Stanford’s global digital policy incubator and the XPRIZE foundation’s June 11th Event

From here to autonomy: Lessons learned from human-automation research

Situation awareness in future autonomous vehicles: Beware of the unexpected

A computational cognition model of perception, memory, and judgment

Project aura: Toward distraction-free pervasive computing

Cognitive failure and perceived workload in vigilance performance

In M. Mouloua & R. Parasuraman (Eds.),

In search of vigilance: The problem of iatrogenically created psychological phenomena

DOI:10.1037/a0030214

URL

PMID:23088439

[本文引用: 1]

To what extent are identified psychological processes created in laboratories? The present work addresses this issue with reference to one particular realm of behavior: vigilance. Specifically, I argue that the classic vigilance decrement function can be viewed more realistically and advantageously as an

Some pitfalls in the promises of automated and autonomous vehicles

Differing forms of self-operating transportation are already among us and some have been in operation now for an extended period of time. From elevators and escalators to airport transit trams, we already use many fully automatic systems. Now such technologies are very publicly and prominently penetrating into the on-road environment of everyday personal vehicle usage. The present article raises and addresses a number of the specific and more general human factors/ergonomic issues associated with such an evolutionary step. One particular concern is that of identified responsibility when such systems fail to perform flawlessly. The ways in which this (r)evolution will impact the social and cultural fabric of affected societies is also considered. Further observations as to the vector of the future characteristics of these vehicular forms and how they and other autonomous systems will affect our world are examined. The very future of the human experience depends upon the ways in which such systems are designed, enacted and integrated into everyday life and these are fundamentally ergonomic endeavours.Practitioner's Summary: The prominence of practitioners working on advanced human-machine systems will increase with public concerns surrounding self-driving vehicles. Driverless cars are not only a technological step but they will also exert widespread effects throughout society. Practitioners should prepare for these broad socio-technical challenges in an evolving, autonomous world.

Explaining explanation, part 2: Empirical foundations

Artificial intelligence and the future of work: Human-AI symbiosis in organizational decision making

A conceptual framework of autonomous and automated agents

Machine learning and cognitive ergonomics in air traffic management: Recent developments and considerations for certification

A comparison of shared and distributed situation awareness in teams through the use of agent-based modelling

IEEE P7003TM standard for algorithmic bias considerations

A common goal for the brightest minds from Stanford and beyond: Putting humanity at the center of AI

Explanation and abductive inference

Similarities and differences between human-human and human-automation trust: An integrative review

Architectural framework for exploring adaptive human-machine teaming options in simulated dynamic environments

Intelligent agent transparency in human-agent teaming for multi-UxV management

DOI:10.1177/0018720815621206

URL

PMID:26867556

[本文引用: 1]

OBJECTIVE: We investigated the effects of level of agent transparency on operator performance, trust, and workload in a context of human-agent teaming for multirobot management. BACKGROUND: Participants played the role of a heterogeneous unmanned vehicle (UxV) operator and were instructed to complete various missions by giving orders to UxVs through a computer interface. An intelligent agent (IA) assisted the participant by recommending two plans-a top recommendation and a secondary recommendation-for every mission. METHOD: A within-subjects design with three levels of agent transparency was employed in the present experiment. There were eight missions in each of three experimental blocks, grouped by level of transparency. During each experimental block, the IA was incorrect three out of eight times due to external information (e.g., commander's intent and intelligence). Operator performance, trust, workload, and usability data were collected. RESULTS: Results indicate that operator performance, trust, and perceived usability increased as a function of transparency level. Subjective and objective workload data indicate that participants' workload did not increase as a function of transparency. Furthermore, response time did not increase as a function of transparency. CONCLUSION: Unlike previous research, which showed that increased transparency resulted in increased performance and trust calibration at the cost of greater workload and longer response time, our results support the benefits of transparency for performance effectiveness without additional costs. APPLICATION: The current results will facilitate the implementation of IAs in military settings and will provide useful data to the design of heterogeneous UxV teams.

A theoretical framework for designing human-centered automotive automation systems

A state of science on highly automated driving

Collision between a car operating with automated vehicle control systems and a tractor-semitrailor truck near Williston, Florida, May 7, 2016

Humans and automation: Use, misuse, disuse and abuse

DOI:10.1518/001872097778543886 URL [本文引用: 1]

Machine behaviour

DOI:10.1038/s41586-019-1138-y

URL

PMID:31019318

[本文引用: 1]

Machines powered by artificial intelligence increasingly mediate our social, cultural, economic and political interactions. Understanding the behaviour of artificial intelligence systems is essential to our ability to control their actions, reap their benefits and minimize their harms. Here we argue that this necessitates a broad scientific research agenda to study machine behaviour that incorporates and expands upon the discipline of computer science and includes insights from across the sciences. We first outline a set of questions that are fundamental to this emerging field and then explore the technical, legal and institutional constraints on the study of machine behaviour.

Towards using transparency mechanisms to build better mental models

The horse has bolted! Why human factors and ergonomics has to catch up with autonomous vehicles (and other advanced forms of automation)

Modeling driver behavior in a cognitive architecture

How in the world did we ever get into that mode: Mode error and awareness in supervisory control

A framework for developing and using shared mental models in human-agent teams

Distributed situation awareness

State-of-science: situation awareness in individuals, teams and systems

Ironies of automation: Still unresolved after all these years

Approaching full autonomy in the maritime domain: Paradigm choices and human factors challenges

Human-AI cooperation to benefit military decision making

Single pilot operations in domestic commercial aviation

The five key questions of human performance modeling

Identifying problems and generating recommendations for enhancing complex systems: Applying the abstraction hierarchy framework as an analytical tool

Applications of an interaction, process, integration, and intelligence (IPII) design approach for ergonomics solutions

Toward human-centered AI: A perspective from human-computer interaction

From automation to autonomy and autonomous vehicles: Challenges and opportunities for human-computer interaction

Effectiveness and acceptance of the intelligent speeding prediction system (ISPS)