1 问题提出

公共安全是维持社会稳定的重要因素之一。人工智能作为近年来逐渐成熟的技术, 在社会公共安全领域得到了广泛应用, 如人脸识别在公共安全视频监控体系中的应用已产生了较为理想的成效(苏光大, 2015)。然而, 人脸识别仅能进行个人外在的身份识别, 无法识别其内在情绪。情绪识别可以为公共安全防范提供必要的线索, 如当被识别对象存在潜在危害公共安全的企图而刻意掩饰真实情感时, 隐藏情绪的准确识别将起到预警作用, 这对维护社会公共安全具有重要价值和现实意义。情绪识别是一个复杂、快速的过程, 需要计算机与心理学等多学科进行深入交叉研究。随着计算机的快速发展与情绪探索价值的日益突出, 挖掘人们的内在情绪已经成为人工智能领域积极探索的难题。

情绪是“知情意”三种基本心理过程之一, 它以个体的愿望和需要为基础, 表现为人对客观事物的态度体验及相应的行为反应。隐藏情绪是一种特殊的情绪, 本文中, 隐藏情绪是指一种未充分表现、刻意掩饰、难以被他人察觉的情绪。面部表情是情绪最主要的行为表现, 可以分为宏表情和微表情。微表情是指人们在试图隐藏情绪、压抑情绪信号, 却无法完全压抑时快速泄露出来的表情, 因其无法被有意识地抑制, 被认为是反映了人们压抑的真实情绪。因此, 微表情被认为是揭示隐藏情绪的一条重要通道(ten Brinke et al., 2012; Frank & Svetieva, 2015)。Haggard和Isaacs的研究发现, 微表情与自我防御机制有关, 能够表达隐藏起来的情绪(Haggard & Isaacs, 1966)。1969年, Ekman和Friese发现了微表情:他们在观看一个掩盖自杀企图的抑郁症患者录像时发现, 虽然患者无任何异常表现, 但慢速播放其录像时却发现了一个强烈痛苦的表情, 此表情持续时间仅为1/12秒(Ekman & Friesen, 1969)。此后的研究也表明, 微表情与宏表情之间最大的差别在于持续时间。微表情本质上属于一种非常快速的表情, 持续时间仅在1/25秒至1/5秒, 所以仅用人眼难以察觉(吴奇, 申寻兵, 傅小兰, 2010)。由于在相当短的时间内捕捉到微表情极其困难(Ekman, 2003a, 2009; Ekman & O'Sullivan, 2006), 利用计算机技术精准地识别微表情成为了研究隐藏情绪的重点。本研究通过计算机视觉技术来精准的定位面部肌肉运动, 并通过事件相关电位(event-related potential, ERP)和功能性磁共振成像(functional magnetic resonance imaging, fMRI)找出微表情的中枢神经系统反应特征, 确定微表情的脑电激活模式和脑区定位, 从而得出真实的情绪。除了微表情以外, 面部颜色、眼动模式(计算机领域中称视线估计)和生理信号也是隐藏情绪的其他潜在表现形式。本研究利用计算机视觉等人工智能技术, 通过研究融合微表情、面部颜色等多模态信息, 对隐藏情绪进行分析和识别, 并面向社会公共安全具体场景:1)精神疾病患者两害行为风险评估; 2)服刑人员会见场景, 开展隐藏情绪分析与识别验证应用。该研究属于多学科交叉共融, 且理论与实践结合, 具有科学意义和应用价值, 可以为提高社会公共安全提供理论基础和关键技术, 满足公共安全领域重大需求, 促进人工智能与公共安全应用的融合发展。

2 研究现状

2.1 理论模型的研究现状

情绪的外在表现为面部表情、姿态表情和语调表情, 其中最主要的是面部表情。下面将重点阐述其相关研究。早在1979年关于表情的研究中就发现, 面孔不同部位信息在表情的判断中作用不同(Bassili, 1979)。后来又有研究者提出, 面部肌肉的反馈信息在表情识别中有重要作用。其提出的面部反馈假设(McIntosh, 1996)指出:外部输入的情绪信息传到皮下运动控制中心, 自动激发出面部表情, 皮下运动控制中心再发出面部肌肉收缩指令(如皱眉等), 信息反馈到大脑皮层, 从而使大脑产生情绪体验, 达到对表情的识别。综上所述, 情绪与面部肌肉之间存在着千丝万缕的联系。Ekman在《面部运动编码系统》一书中(Ekman, Friesen, & Hagar, 2002), 充分标注了面部的所有运动单元(Action Unit, AU), 说明了如何组合各个AU做出相应的表情, 并且对各AU组合之间的不同之处进行了讨论, 例如, AU6+AU12+ AU25+AU27组合在一起展现出的表情为高强度的大笑; AU12+AU25+AU26组合在一起展现出的表情为低强度的笑容等(Ekman et al., 2002), 这使得通过分析面部肌肉的运动进而识别情绪成为了可能。其后又有人总结了面部肌肉的部分运动与宏观表情识别的外在联系:眼睛可应用于恐惧表情的识别; 嘴唇可应用于高兴和惊讶表情的识别, 例如, 惊讶时通常嘴唇部位是张开的, 而高兴时嘴角是上扬的。另外, 鼻子下部和嘴唇部位对厌恶的识别也有重要作用(Smith & Schyns, 2009)。同年Frank等发现, 面部肌肉运动受两条在功能上可以分离的神经通路控制(Frank et al., 2009), 其中一条通路(锥体束, Pyramidal tract)控制自主的面部肌肉运动, 另一条通路(外锥体束, Extrapyramidal tract)控制不自主的面部肌肉运动。由此可知, 面部表情可以通过面部肌肉的运动来进行分析。

在隐藏情绪的特点方面, 曾有研究者发现, 隐匿异常情绪的人通常会体验到恐惧、内疚或得意(Weiss, 2011)。相较于情绪正常的人而言, 情绪异常的人在隐匿自己情绪的时候, 会有更少的眼动, 瞳孔直径会增大, 并且会出现注视回避等生理或行为线索(梁静 等, 2014)。因此, 为了更准确的检测和识别隐藏的异常情绪, 需要对隐藏情绪的表达规律进行探索, 在以往研究的基础上进行技术革新, 实现对其主要表现形式微表情中存在的肌肉运动单元精准定位, 从而有效甄别隐藏情绪。

2.2 相关技术的研究现状

本研究构想中将以微表情的检测和识别为主, 辅以面部颜色、注视估计和非接触式心率检测等多个通道, 对隐藏情绪进行分析和识别。下面对相关技术研究现状进行分别叙述。

2.2.1 数据获取

(1)微表情数据获取

微表情是一种持续时间极短、不易被察觉的面部动作, 它往往能反映出个体真实的情绪。微表情是理解人类真实情绪的重要窗口, 可以用于非接触无感知的欺骗检测, 在国家安全、司法实践、临床实践、广告与消费、金融等领域有广阔的应用前景。然而与微表情相关的研究近10年间才受到研究者们的关注。自从2018年, 中国科学院心理研究所、英国曼彻斯特都会大学、芬兰奥卢大学和马来西亚多媒体大学在IEEE International Conference on Automatic Face and Gesture Recognition上开始每年组织国际微表情识别大赛(Yap, See, Hong, & Wang, 2018), 越来越多的人参与到微表情检测和识别的研究中来。芬兰奥卢大学Matti Pietikäinen团队针对图像描述子通常只描述微表情人脸的表观信息, 而没有人脸的几何信息的问题, 提出了基于积分投影的判别式时空局部二值模式(Huang et al., 2019)。清华大学的刘永进团队提出了一种主方向平均光流特征(MDMO)的微表情识别方法(Liu et al., 2016)。复旦大学张军平团队利用光流提出人脸动态映射来刻画微表情运动粒度的不同(Xu, Zhang, & Wang, 2017)。东南大学郑文明团队使用域重新生成的方法对微表情实现了跨库识别(Zong, Zheng et al., 2018)。同时他们也提出一种层级的时空描述子来识别微表情(Zong, Huang, Zheng, Cui, & Zhao, 2018)。中山大学的郑伟诗团队在LBP-TOP等低级特征上应用多任务学习提取中级特征来对微表情进行识别(He, Hu, Lu, & Zheng, 2017)。马来西亚多媒体大学John See团队使用时序插值方法(TIM), 动态模式分解(DMD)和稀疏动态模式分解 (DMDSP)来进行微表情识别(le Ngo, See, & Phan, 2017)。

我们针对微表情样本量小, 不适合采用深度学习算法进行自动识别的问题, 提出两步迁移学习的思想, 应用于微表情识别(Wang et al., 2018)。第一步, 从大量的宏表情数据中迁移一部分知识; 第二步, 把微表情视频的每一帧看作为一个样本。我们也从研究多模态融合角度来提高微表情识别率, 提出了稀疏张量CCA (Sparse Tensor CCA, STCCA) (Wang, Yan, Sun, Zhao, & Fu, 2016)。STCCA通过规则化的低秩矩阵逼近获得稀疏解, 利用STCCA寻找一个子空间, 使得微表情视频数据与其相应的LBP-TOP编码数据之间的相关性在子空间中最大。另外, 我们还提出主方向光流差分析法从长视频中检测出微表情(Wang, Wu, Qian, Li, & Fu, 2017)。

(2) 面部颜色数据获取

也有研究表明, 随着人们情绪的变化, 皮肤外观会发生改变, 变化的关键指标之一是面孔颜色(Jimenez et al., 2010)。其后Benitez-Quiroz等在美国科学院会刊(PNAS)发表的研究证明, 人们可以通过使用面孔的颜色特征成功解码情绪(Benitez-Quiroz, Srinivasan, & Martinez, 2018)。面孔颜色作为微表情识别的一种方式, 与肌肉线索一并为隐藏情绪的识别提供了重要依据。当隐藏情绪发生时, 一些面部肌肉运动单元出现运动并组合成某一种微表情(Ekman, 2009), 同时因为面部含有丰富的血管分布, 这些血管中的血流以及血液成分的变化会使面部产生可见的颜色变化(Benitez- Quiroz et al., 2018)。已有研究表明, 面孔颜色与血红蛋白的浓度有关, 而血流以及血液成分的变化会使血红蛋白浓度发生变化, 从而引起肤色的变化(Moretti, Ellis, & Mescon, 1959)。例如, 愤怒时AU4+AU5+AU7+AU24发生运动(Ekman et al., 2002), 血管中的血流速度变快, 流量变大, 血红蛋白浓度变大, 面部会显示出红色。

(3) 眼动数据获取

有研究表明说谎组和对照组在眼动模式上有明显的区别(Derrick, Moffitt, & Nunamaker, 2011)。计算机视觉中的注视估计(gaze estimation)可以使用摄像头来估计人的视线方向, 从而进一步地推断出眼动模式。对注视估计进行系统深入研究的有美国伦斯勒理工学院纪强教授团队,该团队在2016年提出了一种基于深度传感器Kinect进行实时眼睛注视跟踪的方法(Wang & Ji, 2016b), 并结合眼睛模型和眼睛外观进行注视估计和注视跟踪(Wang & Ji, 2016a)。然后在2017年提出了基于三维模型的单摄像头注视估计方法(Wang & Ji, 2017), 该方法实现了即时和便携式的眼球注视跟踪。在2018年进一步提出了利用人眼注视跟踪过程中的4个自然约束条件的隐式校准方法进行注视估计的方法(Chen et al., 2019)。

此外, Xiong等在2014年提出了一种基于RGBD采用离线构建的个性化三维人脸模型进行非红外跟踪眼睛注视的方法(Xiong, Liu, Cai, & Zhang, 2014)。Zhang等在2015年提出了一种在室外基于眼睛外观的注视估计方法(Zhang, Sugano, Fritz, & Bulling, 2015), 该方法使用多模态卷积神经网络, 在最具挑战性的交叉数据集评估中显著优于现有方法。Krafka等在2016年提出了一种基于注视捕获进行卷积神经网络训练达到注视跟踪的方法(Krafka et al., 2016)。Sabharwal等在2017年提出了一种在平板电脑自然使用过程中姿势不受限制的情况下使用前置摄像头进行未校准的注视估计, 采用基于多级HoG特征和随机森林回归器的基础算法分析各种实际因素对注视估计精度影响的方法(Huang, Veeraraghavan, & Sabharwal, 2017)。Cheng等在2018年提出了一种不对称的回归估计网络(Cheng, Lu, & Zhang, 2018), 该方法的核心是左眼和右眼在注视估计时所观察到的“两只眼睛不对称”的概念。同年, Fischer等提出了一种基于眼睛外观的深度卷积神经网络的实时注视估计方法(Fischer, Jin Chang, & Demiris, 2018), 提高了处理新数据集中不同图像的性能。

(4) 生理信号数据获取

情绪的改变, 尤其是当发生隐藏情绪时, 通常会伴随生理信号的变化。基于遥测光电脉搏容积成像的生理信号检测是非侵入式的方法, 因为不需要与被检测者皮肤产生直接接触即可获得心率等生理信号而受到研究者的青睐。心脏的周期性收缩和舒张将血流输送到全身从而导致血液容积发生变化, 由于血液和血管等组织对于不同波段光的吸收和反射能力的不同, 导致脸部或手指等血管分布较为丰富的部位产生细微的颜色变化。Verkruysse首次提出了在可见光作为光源的情况下使用普通光学摄像头检测人体心率的可行性(Verkruysse, Svaasand, & Nelson, 2008)。Verkruysse通过分析在可见光下拍摄的一段人脸视频获得了心率信号。利用这个微弱的信号, 麻省理工学院的Poh等提出了一种基于盲源分离算法的实现从人脸视频图像中提取心率信号的非接触式检测方法(Poh, McDuff, & Picard, 2010)。后续很多研究开始关注噪声、伪迹消除方法, 如被试运动、面部表情、皮肤颜色、光照改变等(Chen et al., 2019)。消除环境光噪声方面, 主要有两种方式, 一是通过信号处理方法直接将光照变化信号从脉搏信号中分离出来(Chen et al., 2015), 另一个思路是将除面部区域外的非皮肤背景区域作为噪声参考(Cheng, Chen, Xu, & Wang, 2017)。抗运动干扰的方法大致可以分为盲源分析方法, 如独立成分分析(ICA)、主成分分析(PCA), 将运动信号成分分离(Poh et al., 2010); 基于色度模型的方法, 如CHROM、POS, 通过分析皮肤颜色模型区分运动信号与脉搏信号(Wang, den Brinker, Stuijk, & de Haan, 2017); 基于运动补偿的方法, 包括全局运动补偿和局部运动补偿, 来消除头部平移和旋转的影响(Cheng et al., 2017)。

心率是一段时间内心脏跳动的次数, 对情绪变化并不十分敏感, 心率变异性(Heart Rate’s Variability, HRV)是心脏的每次跳动在时间上间隔的变化量。HRV信号中蕴含了有关心血管调节的大量信息, 对这些信息的提取和分析可以定量评估心脏交感神经和迷走神经活动的紧张性、均衡性及其对心血管系统活动的影响。近年来的相关研究工作表明, 非接触的光电脉搏容积成像方式可以在环境光照明条件下仅通过低成本的成像设备准确地遥测心率变异性信号。研究表明, 情绪改变(如高压紧张)会对HRV产生影响, 如在心理负荷下, HRV 高频(HF)成分降低(Hjortskov et al., 2004), 在高度注意状态下低频(LF)和HF的绝对值均下降(Moses, Luecken, & Eason, 2007)。然而已有工作的目的是研究测量结果的准确性, 并非研究生理信号与情绪的相关性及其在隐藏情绪监测中的潜在应用。

2.2.2 多维度数据融合技术研究现状

隐藏情绪是一种复杂的心理行为, 往往同时伴随着生理指标和外在的行为表现, 仅使用单一通道很难提高隐藏情绪的识别率。因此, 充分利用多通道数据融合是提高隐藏情绪识别率的重要途径。现代数据融合的基础理论建立于20世纪前叶, 多数据集的聚合分析方向在1960年底到1970年初有了较大的发展, 如平行因子分析法(Carroll & Chang, 1970)、多数据集典型相关性分析方法(Kettenring, 1971)和张量分解方法。

2.3 应用场景研究现状

我们的隐藏情绪分析和识别方法将分别在精神疾病临床与司法两个不同的场景, 对其进行应用验证和修正。

2.3.1 在医院临床的应用研究现状

(1) 精神疾病患者两害行为识别的必要性

精神疾病患者在精神症状和精神因素影响下, 情绪容易受到激发, 进而发生两害行为(即危害自身或他人的危险行为), 具有隐蔽性、经常性和严重性等特点(卢婉波, 徐银儿, 史尧胜, 2015), 严重影响家庭正常生活及社会公共安全。精神疾病患者的两害行为主要体现在重性抑郁障碍(Major Depression Disorder, MDD)患者、双相情感障碍(Bipolar Depression, BD)患者和精神分裂症(Schizophrenia, SZ)患者人群中。我国学者通过分析2200例重性精神疾病患者的出院信息, 发现重性精神疾病患者中有52.73%具有两害行为, 其中BD患者和SZ患者分别占47.55%和43% (范萌, 傅可月, 2016)。世界卫生组织报道全球每年自杀未遂者高达100万。资料显示我国临床MDD中有15%患者死于自杀(Vaillant, 2004)。BD仅次于MDD, BD患者自杀风险是正常人的15倍(Pompili et al., 2013), 并且SZ患者死亡的常见原因是自杀。因此, 分析精神疾病患者的两害行为, 寻找早期预测两害行为的客观指标, 有助于早期识别两害行为, 降低其社会风险, 对临床和社会公共安全具有重要的意义。

(2) 情绪调节机制研究有助于早期预防精神疾病患者的两害行为

既往研究发现情绪调节自我效能感于攻击行为显著负相关, 并且情绪调节在攻击等行为中具有中介调节作用(曹杏田, 张丽华, 2018; 吴晓薇, 何晓琴, 唐海波, 胡青竹, 蒲唯丹, 2015), 可通过调整情绪调节策略来降低两害行为的发生(Miles et al., 2017)。精神疾病患者常伴有情绪调节障碍, 偏向负性认知模式, 是发生两害行为的高风险因子(Brausch & Woods, 2019; Forkmann et al., 2014)。精神疾病患者在发生两害行为尤其攻击行为时, 伴有情绪不稳定, 易激惹等特征(厉爱婷 等, 2015)。在临床上, 精神疾病患者在接受治疗后的精神症状有所缓解, 但情绪调节功能并未完全恢复, 他们容易将真实情感隐藏起来。因此, 早期识别其隐藏情绪, 探索情绪调节机制对于预防两害行为的发生具有重要作用。

情绪调节是个体对情绪的发生、体验以及表达施加影响的过程, 经常采用的情绪调节策略包括认知重评策略和表达抑制策略(Gross & John, 2003)。MDD、BD和SZ患者个体表现出情绪调节异常, 脑神经机制表现为前额叶皮层和杏仁核的异常连接(Phillips & Swartz, 2014)。并且, 研究发现习惯采用认知重评策略的MDD缓解期患者, 在看到负性图片时, 其前额叶皮层的激活度升高; 而惯用表达抑制的MDD缓解期患者的眶额叶皮层的激活度降低, 杏仁核的激活度升高(Abler et al., 2010; Fitzgerald et al., 2017; Vanderhasselt, Baeken, van Schuerbeek, Luypaert, & de Raedt, 2013)。由此可见, 认知重评和表达抑制机制有助于揭示精神疾病患者负性情绪的发生机制。同时, 揭示精神疾病患者的不同情绪调节策略机制, 针对性地改善其不良情绪, 有助于患者的康复, 保持情绪的稳定, 降低其两害行为发生的风险。

(3) 基于微表情技术识别不同情感调节策略的精神疾病患者

研究发现认知重评条件下负性情绪体验相对较少, 厌恶的面部表达行为也显著减少, 受试者的皮肤电水平、呼吸频率、心血管的交感神经激活减弱; 采用表达抑制策略时, 受试者的皮肤电水平增加。可见, 认知重评策略会降低个体的生理反应, 而表达抑制策略则增强个体的生理反应。有些学者采用功能核磁共振和表情识别相结合的方式对MDD患者的表情进行了探讨, 发现MDD患者在感知动态喜悦时在面部运动方面存在差异, 并且MDD患者对于悲伤的感知敏感度大于中立的感知。随着医学技术的发展, 采用综合模式评估抑郁的方法越来越多, 因此有些学者便对抑郁表情的研究进行了梳理。学者们将表情作为MDD的客观检测标准的可行性进行分析, 同时指出了展开MDD患者微表情识别及训练的必要性。综上, 分析MDD患者的微表情, 利用微表情技术识别情绪认知重评策略和表达抑制策略的精神疾病患者, 探讨不同调节策略与两害行为的关系, 以此构建两害行为的风险评估系统, 是本研究要解决的问题。

2.3.2 在司法中的应用研究现状

情绪识别在公共安全领域应用的重要性在于, 其可以在公共场所精准定位到情绪异常的有犯罪意向的个体或团体, 也有助于人们寻找欺骗线索(梁静 等, 2013)。其中, 微表情与欺骗关系密切(Ekman, 2003b; Ekman & Sullivan, 2006)。微表情一般不能自主控制, 是与谎言识别关系密切的内部心理机制的外部表现(Ekman & Friesen, 1974)。Porter和ten Brinke在2008年的研究发现当人们试图做出欺骗性的动态表情时, 经常伴随着微表情的发生(Porter & Brinke, 2008)。因此, 识别微表情可以作为欺骗检测的一个有效线索和辅助手段(Akehurst, Köhnken, Vrij, & Bull, 2010), 且研究发现通过识别微表情来进行欺骗检测, 准确率可达到70% (Frank et al., 2009)。由于欺骗线索有行为线索、认知线索、生理线索等(DePaulo et al., 2003; Frank et al., 2009; Vrij & Granhag, 2012)。因此, 表情识别(包括微表情识别和姿态表情识别)可以帮助人们寻找欺骗线索(梁静 等, 2013; 吴奇 等, 2010)。Meservy等在2008年试图从姿态表情中提取欺骗与真实的线索以在反恐实践中进行应用, 结果发现两类别的正确率能够达到71%, 显著高于随机水平(Meservy, Jensen, Kruse, Burgoon, & Nunamaker, 2005)。在现实生活中, 服刑人员改造是公共安全关注的重要方面, 监狱会见场景中同样存在着欺骗行为, 例如, 在服刑期间, 服刑人员可能因为家庭变故或在狱中改造的不顺利等原因而抑郁, 严重者甚至存在自杀的念头, 但是当其与亲人见面时却有意隐瞒自己的真实想法和情绪。基于此, 我们将研究在监狱会见场景中识别服刑人员隐藏情绪的适用性。

2.4 现有研究的不足

已有研究对情绪识别的机理、关键技术与应用研究等方面均做出了有益的探索, 虽然情绪识别建模的相关研究相对较多, 但针对隐藏情绪的研究却很少。微表情是揭示隐藏情绪的一条重要通道, 对微表情检测和识别的研究也已经有近10年, 但却仍然无法应用到实际场景中。这主要是由于现有研究大部分在实验室内进行, 实验室情境和现实情境存在较大的差距, 实验室研究中无法达到高风险水平, 因此为隐藏情绪而出现微表情的概率也较低。实验室研究只能作为隐藏情绪识别应用研究的起点, 要有效地将隐藏情绪应用于实际生活中还需要进一步开展更具生态效度的研究。

追溯对微表情的研究历史发现, 微表情是心理学家在观察一位抑郁症患者的谈话视频中发现的。在本研究中依托参与单位中首都医科大学附属北京安定医院的重症抑郁障碍、双相情感障碍和精神分裂症患者群, 获取两害行为风险评估场景数据。于此同时,发挥中国科学院心理研究所在科技部国家重点研发计划“面向服刑人员改造的心理和行为采集与评估技术研究”中课题牵头单位的优势, 利用对接司法部在5个省市的示范监狱, 获取服刑人员会见场景数据。

基于以上数据,训练出更具鲁棒性的微表情检测和识别系统, 同时辅以人脸颜色、注视估计和非接触式心率等多通道来分析和检测隐藏情绪。最后,将通过开闭环两个不同的场景, 对系统和方法进行验证和修正。

3 研究构想

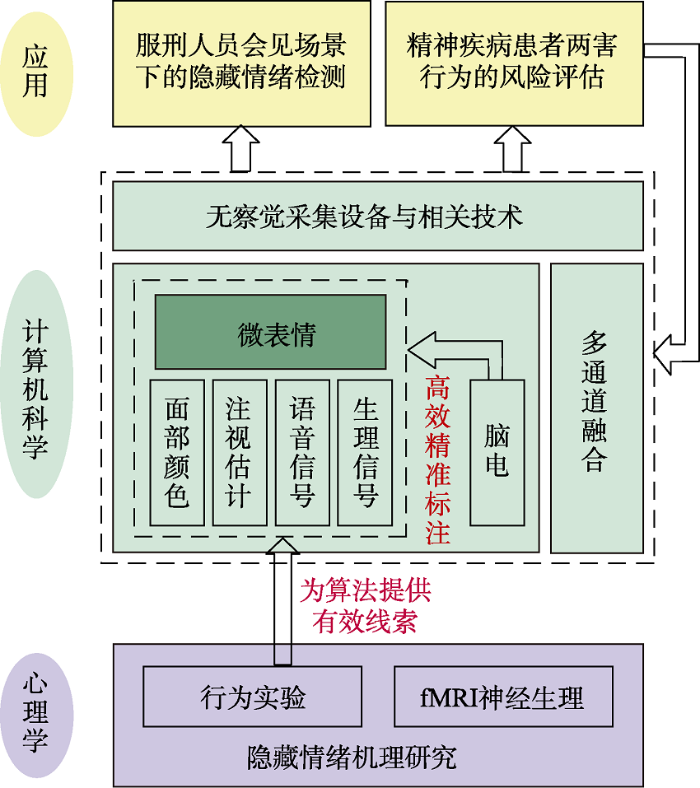

本研究将通过综合使用计算机科学、认知心理学和医学相关知识, 以微表情为主要通道, 辅以面部颜色、视线方向和心率等多通道数据对面向公共社会安全的隐藏情绪进行分析。主要研究内容可以分为基础理论、关键技术和应用验证三个层次, 如图1所示。在基础理论和模型研究层次, 将重点研究和探索隐藏情绪的外在表达特点和神经反应模式, 探讨精神疾病患者不同情绪调节策略的神经影像机制, 并建立以微表情为主的多通道隐藏情绪表达模型, 为关键技术层次提供理论支持。在关键技术层次, 针对公共场合的特点, 将首先研究无察觉采集设备和相关技术。然后以微表情为主, 面部颜色变化为新突破, 注视方向变化和心率变化变化为辅, 对隐藏情绪进行多通道分析和融合。为了解决标注微表情耗时耗力的问题。我们研究微表情的脑电特征, 通过脑电对自然状态下的微表情数据进行高效精确标注。在应用验证层次, 面向闭环情境, 为识别精神疾病患者隐藏的两害行为风险, 通过神经影像特征将精神疾病患者情绪调节分为认知重评策略组和表达抑制策略组, 利用微表情、人脸颜色变化、视线方向和心率等特征识别认知重评策略组和表达抑制策略组。面向开环情境, 在服刑人员会见场景下, 对系统进行验证。

图1

3.1 基础理论和模型的研究构想

本研究的目的是通过心理学行为实验, 探究隐藏情绪的表达特点和生理基础, 为研发基于微表情的隐藏情绪识别系统提供科学依据。首先, 我们从认知心理学角度出发, 通过设定的实验场景和实验任务来研究隐藏情绪的线索, 采集严格控制条件下的微表情、注视估计等数据, 结合人工编码和计算机检测和识别技术进行标定和建库, 发现微表情及其他的隐藏情绪特征, 为后续识别算法提供有效线索。其次, 我们将脑电技术和功能性核磁共振技术加入到心理学行为实验中, 对隐藏情绪的中枢神经反应模式加以探索以找到微表情的生理基础, 从而揭示隐藏情绪的表达机制, 为隐藏情绪的特征选择、优化与建模提供基础。

为了规避潜在风险, 人们需要准确识别隐藏情绪, 但是只通过肉眼观察面部的细微运动来感知隐藏情绪较为困难。人的判断是经过复杂的大脑活动后作出的反应, 所以要通过生理和行为多个指标来揭示人是如何识别隐藏情绪。为此, 需研究面部隐藏情绪的识别与一般情绪识别的差异, 并通过实验模拟真实场景中人如何识别隐藏情绪, 找到高生态效度下的隐藏情绪识别线索, 建立多维度的隐藏情绪识别模型, 进一步指导计算机自动识别隐藏情绪的算法。

不同情绪调节策略的精神疾病患者存在的两害行为风险具有差异性。为了探究精神疾病患者异常的情绪调节机制, 本研究利用神经影像分析技术, 分析患者与情绪调节相关的特异性神经影像特征, 提取与两害行为风险评估密切相关的神经生物指标。此外, 本研究利用深度学习方法, 探讨认知重评策略组和表达抑制策略组的微表情、人脸颜色、视线方向和心率等多通道特征, 并融合多通道特征识别认知重评策略组和表达抑制组, 进而构建精神疾病患者两害行为风险评估模型。

3.2 关键技术的研究构想

针对公共场合, 我们首先研究无察觉采集设备和相关技术。无察觉采集设备将使用PTZ摄像机, 它可以通俗地理解为云台控制加焦距调节。由于PTZ摄像机的定速策略会导致人脸图像模糊, 因为也需要进一步解决这一问题以便采集有效数据。同时, 也需要进行人脸高精度几何模型重建和复杂光照条件下鲁棒面部关键点检测, 为后续的多通道获取提供准备。

在微表情研究中, 用光流技术去研究人脸对齐和微表情检测的问题; 用稀疏技术去提取细微的微表情运动特征; 用深度学习技术对微表情进行识别。此外, 还研究微表情的时空特征、小样本问题和样本不均衡问题。最新研究表明, 人脸彩色的变化可以独立于表情去反映人的真实情绪。为此, 研究中将寻找一种颜色空间, 在这个空间中使得颜色对情绪更有判别性。眼睛是心灵的窗口, 拟研究人眼的结构模型, 并根据该模型, 建立一个注视估计模型, 来估计人的视线躲闪等指标, 以此辅助微表情对隐藏情绪的分析。

针对现有非接触式心率测量系统容易受运动伪迹干扰的问题, 研究抗运动干扰的非接触式心率、心率变异性测量方法。分析运动伪迹引起噪声对不同颜色空间的影响区别, 以及运动伪迹不同于心率信号的频谱特性, 进行视频图像预处理、脉搏波信号去噪及信号增强算法, 在此基础上研究敏感区域跟踪匹配并结合盲源分析的运动伪差去除算法。最后我们要研究不同通道的数据融合方法, 对多通道的数据进行综合建模来分析隐藏情绪。研究融合不同模态的信息将能够显著提高情绪识别算法的准确率。

现在的微表情数据库中诱发的微表情都是包含在中性表情里的微表情, 即微表情的前后都是中性表情。而在现实生活中, 这种情况很少出现。比如说“笑里藏刀”是指在笑的宏表情中包含“厌恶”或者“憎恨”的微表情。在实验中很难诱发这种自然状态下的微表情。根据微表情的起源, 微表情是在和抑郁症患者交谈中发现的。所以我们拟采用和抑郁症患者谈话的方式去诱发真实场景下的微表情。然而对真实条件下的微表情数据进行标注是相当困难的, 所以我们拟采用脑电作为微表情的精准标注。因此, 我们需要研究脑电和微表情对应关系以及脑电和隐藏情绪的对应关系。

3.3 应用验证的研究构想

在应用验证部分, 拟分别建立开环和闭环情境下的典型应用, 并对研究成果进行实践验证, 以进一步完善面向社会公共安全的异常隐藏情绪分析与识别方法。闭环情境下的应用拟研究精神疾病患者两害行为的风险评估系统, 开环情境下的应用拟研究服刑人员会见场景下的隐藏情绪检测系统。

3.3.1 精神疾病患者两害行为的风险评估系统

针对精神疾病患者由于存在情绪调节障碍, 导致负性情绪较多, 而容易发生两害行为的这一问题, 我们拟采集精神疾病患者的视频、EEG和功能磁共振数据, 利用神经影像技术分成认知重评策略和表达抑制策略组, 结合微表情数据, 构建分类预测模型, 为精神疾病患者两害行为的发生风险评估提供客观依据, 并构建两害行为风险评估系统。

3.3.2 服刑人员会见场景下的隐藏情绪检测系统

针对服刑人员行为线索隐匿性强, 防范心理严重, 潜在心理活动和行为意图难于挖掘的这一问题, 我们拟在远程视频会见、物理会见、亲情电话场景下, 采集服刑人员的微表情数据, 对服刑人员的愤怒、焦虑、抑郁等典型负性情绪建立识别与预测模型, 同时结合服刑人员狱内表现、狱警评价等业务数据, 为服刑人员的危险性评估提供数据支持。

4 理论构建与创新

本研究从微表情的实际应用出发, 利用微表情能揭示隐藏情绪这一特点, 结合面部颜色、视线方向和脑电信号等特征, 进行多通道融合来提高对隐藏情绪分析的可靠性。开展多学科交叉研究, 充分利用心理学在微表情识别, 情绪分析及建模、脑电信号分析方面的优势和研究基础, 计算机科学相关的技术积累, 和精神疾病领域的专业特色和临床科学研究的基础。本研究的主要创新点包括:

在基础理论研究方面, 使用认知心理学、神经生理学、医学等手段研究微表情和隐藏情绪的潜在一致性。

在关键技术研究方面, 探索诱发自然状态下微表情的方法, 同时也使用面部颜色的变化作为隐藏情绪出现的另一佐证。微表情是从纹理层面来分析隐藏情绪, 面部颜色的变化是从颜色层面来分析隐藏情绪。

在应用验证研究方面, 开环场景和闭环场景相结合。在闭环场景中, 根据医生反馈, 不断完善模型。最后将得到的模型在开环场景中进行进一步的验证。微表情是一种持续时间极短的、在人们试图掩饰自己真实情绪时泄露出来的面部动作。这种无法压制的属性使微表情可以应用到国家安全(安检)、司法实践(审讯)、临床医学(医患沟通)、广告与消费(监测消费者的真实态度)等等各个行业领域的欺骗检测。我们的研究目的就是让微表情检测和识别能走出实验室, 在1~2个实际场景示范应用, 从而实现对隐藏情绪进行分析和检测。

参考文献

微表情研究及其应用

微表情是一种持续时间仅为1/25秒至1/5秒的非常快速的表情, 表达了人试图压抑与隐藏的真正情感。本文系统梳理已公开发表的微表情实证研究报告, 对注重于测量微表情识别能力的早期研究、目前基于微表情训练工具(METT)的微表情识别应用研究以及刚刚萌芽的微表情表达研究进行总结分析, 明确指出以往研究中存在的问题, 建议未来研究应探讨METT在不同文化中的有效性, 研究微表情表达的基本特点和主要影响因素, 并注重发展自动化的微表情识别工具。本文提出, 基于微表情的自动谎言识别系统将是微表情研究未来的应用方向之一。

Habitual emotion regulation strategies and depressive symptoms in healthy subjects predict fMRI brain activation patterns related to major depression

Lay persons' and police officers' beliefs regarding deceptive behaviour

Emotion recognition: The role of facial movement and the relative importance of upper and lower areas of the face

DOI:10.1037//0022-3514.37.11.2049

URL

PMID:521902

[本文引用: 1]

In order to investigate the role of facial movement in the recognition of emotions, faces were covered with black makeup and white spots. Video recordings of such faces were played back so that only the white spots were visible. The results demonstrated that moving displays of happiness, sadness, fear, surprise, anger and disgust were recognized more accurately than static displays of the white spots at the apex of the expressions. This indicated that facial motion, in the absence of information about the shape and position of facial features, is informative about these basic emotions. Normally illuminated dynamic displays of these expressions, however, were recognized more accurately than displays of moving spots. The relative effectiveness of upper and lower facial areas for the recognition of these six emotions was also investigated using normally illuminated and spots-only displays. In both instances the results indicated that different facial regions are more informative for different emitions. The movement patterns characterizing the various emotional expressions as well as common confusions between emotions are also discussed.

Facial color is an efficient mechanism to visually transmit emotion

Emotion regulation deficits and nonsuicidal self-injury prospectively predict suicide ideation in adolescents

Analysis of individual differences in multidimensional scaling via an n-way generalization of "Eckart-Young" decomposition

Image sensor- based heart rate evaluation from face reflectance using Hilbert-Huang transform

Video-based heart rate measurement: Recent advances and future prospects

Illumination variation-resistant video-based heart rate measurement using joint blind source separation and ensemble empirical mode decomposition

Cues to deception

Darwin, deception, and facial expression

In P. Ekman, J. J. Campos, R. J. Davidson, & F. B. M. DeWaal (Eds.),

Darwin, deception, and facial expression

In P. Ekman, J. J. Campos, R. J. Davidson, & F. B. M. DeWaal (Eds.),

Lie catching and microexpressions

In Martin (Ed.),

Nonverbal leakage and clues to deception

DOI:10.1080/00332747.1969.11023575 URL PMID:5779090 [本文引用: 1]

Detecting deception from the body or face

From flawed self-assessment to blatant whoppers: The utility of voluntary and involuntary behavior in detecting deception

From flawed self- assessment to blatant whoppers: The utility of voluntary and involuntary behavior in detecting deception

Individual differences in cognitive reappraisal use and emotion regulatory brain function in combat-exposed veterans with and without PTSD

The relation of cognitive reappraisal and expressive suppression to suicidal ideation and suicidal desire

DOI:10.1111/sltb.12076

URL

PMID:24494723

[本文引用: 1]

The differential relations between the emotion regulation strategies

Microexpressions and deception

Individual differences in two emotion regulation processes: Implications for affect, relationships, and well-being

Micromomentary facial expressions as indicators of ego mechanisms in psychotherapy

Multi-task mid-level feature learning for micro-expression recognition

The effect of mental stress on heart rate variability and blood pressure during computer work

DOI:10.1007/s00421-004-1055-z

URL

PMID:14991326

[本文引用: 1]

The aim was to evaluate the cardiovascular and subjective stress response to a combined physical and mental workload, and the effect of rest. Twelve females who had no prior experience of laboratory experiments participated in the study. Computer-work-related mental stressors were either added to or removed from a standardized computer work session in the laboratory. Beat-to-beat blood pressure and electrocardiogram (ECG) were recorded continuously during the experiment. The participants reported subjective experiences of stress in six categories using an 11-point scale before and at the end of the work. Heart rate variability (HRV) variables were calculated from the ECG recordings, and a reduction in the high-frequency component of HRV and an increase in the low- to high-frequency ratio were observed in the stress situation compared to the control session. No changes were seen in the low-frequency component of HRV. The stressors induced an increase in blood pressure compared to baseline that persisted, and for the diastolic pressure it even increased in the subsequent control session. No differences were observed for subjective experience of stress with the exception of a time trend in the exhaustion scale, i.e. a progression in reported exhaustion with time. The results-and the dissociation between HRV and blood pressure variables-indicate that HRV is a more sensitive and selective measure of mental stress. It could be speculated that heart rate-derived variables reflect a central pathway in cardiovascular control mechanisms (

TabletGaze: dataset and analysis for unconstrained appearance-based gaze estimation in mobile tablets

Discriminative spatiotemporal local binary pattern with revisited integral projection for spontaneous facial micro-expression recognition

A practical appearance model for dynamic facial color

Canonical analysis of several sets of variables

Sparsity in dynamics of spontaneous subtle emotions: Analysis and application

A main directional mean optical flow feature for spontaneous micro-expression recognition

Facial feedback hypotheses: Evidence, implications, and directions

Automatic extraction of deceptive behavioral cues from video

In P. Kantor, G. Muresan, F. Roberts, D. D. Zeng, F. Y. Wang, H. Chen, & R. C. Merkle (Eds.),

Emotion dysregulation as an underlying mechanism of impulsive aggression: Reviewing empirical data to inform treatments for veterans who perpetrate violence

Vascular patterns in the skin of the face

Measuring task-related changes in heart rate variability

In

A critical appraisal of neuroimaging studies of bipolar disorder: Toward a new conceptualization of underlying neural circuitry and a road map for future research

Non-contact, automated cardiac pulse measurements using video imaging and blind source separation

Epidemiology of suicide in bipolar disorders: A systematic review of the literature

DOI:10.1111/bdi.12087

URL

PMID:23755739

[本文引用: 1]

OBJECTIVE: Suicidal behavior is a major public health problem worldwide, and its prediction and prevention represent a challenge for everyone, including clinicians. The aim of the present paper is to provide a systematic review of the existing literature on the epidemiology of completed suicides in adult patients with bipolar disorder (BD). METHODS: We performed a Pubmed/Medline, Scopus, PsycLit, PsycInfo, and Cochrane database search to identify all relevant papers published between 1980 and 2011. A total of 34 articles meeting our inclusion criteria were included in the present review. RESULTS: Several prospective follow-up contributions, many retrospective analyses, and a few psychological autopsy studies and review articles investigated the epidemiology of completed suicides in patients with BD. The main finding of the present review was that the risk for suicide among BD patients was up to 20-30 times greater than that for the general population. CONCLUSION: Special attention should be given to the characteristics of suicides in patients with BD. Better insight and understanding of suicide and suicidal risk in this very disabling illness should ultimately help clinicians to adequately detect, and thus prevent, suicidal acts in patients with BD.

Reading between the lies: identifying concealed and falsified emotions in universal facial expressions

DOI:10.1111/j.1467-9280.2008.02116.x

URL

PMID:18466413

[本文引用: 1]

The widespread supposition that aspects of facial communication are uncontrollable and can betray a deceiver's true emotion has received little empirical attention. We examined the presence of inconsistent emotional expressions and

Smile through your fear and sadness: Transmitting and identifying facial expression signals over a range of viewing distances

DOI:10.1111/j.1467-9280.2009.02427.x

URL

PMID:19694983

[本文引用: 1]

It is well established that animal communication signals have adapted to the evolutionary pressures of their environment. For example, the low-frequency vocalizations of the elephant are tailored to long-range communications, whereas the high-frequency trills of birds are adapted to their more localized acoustic niche. Like the voice, the human face transmits social signals about the internal emotional state of the transmitter. Here, we address two main issues: First, we characterized the spectral composition of the facial features signaling each of the six universal expressions of emotion (happiness, sadness, fear, disgust, anger, and surprise). From these analyses, we then predicted and tested the effectiveness of the transmission of emotion signals over different viewing distances. We reveal a gradient of recognition over viewing distances constraining the relative adaptive usefulness of facial expressions of emotion (distal expressions are good signals over a wide range of viewing distances; proximal expressions are suited to closer-range communication).

Crocodile tears: Facial, verbal and body language behaviours associated with genuine and fabricated remorse

Aging well: surprising guideposts to a happier life from the landmark Harvard study of adult development

Inter-individual differences in the habitual use of cognitive reappraisal and expressive suppression are associated with variations in prefrontal cognitive control for emotional information: An event related fMRI study

Remote plethysmographic imaging using ambient light

DOI:10.1364/oe.16.021434

URL

PMID:19104573

[本文引用: 1]

Plethysmographic signals were measured remotely (> 1m) using ambient light and a simple consumer level digital camera in movie mode. Heart and respiration rates could be quantified up to several harmonics. Although the green channel featuring the strongest plethysmographic signal, corresponding to an absorption peak by (oxy-) hemoglobin, the red and blue channels also contained plethysmographic information. The results show that ambient light photo-plethysmography may be useful for medical purposes such as characterization of vascular skin lesions (e.g., port wine stains) and remote sensing of vital signs (e.g., heart and respiration rates) for triage or sports purposes.

Eliciting cues to deception and truth: What matters are the questions asked

DOI:10.1016/j.jarmac.2012.02.004 URL [本文引用: 1]

Micro-expression recognition with small sample size by transferring long-term convolutional neural network

A main directional maximal difference analysis for spotting facial movements from long-term videos

Sparse tensor canonical correlation analysis for micro-expression recognition

Algorithmic principles of remote PPG

Telling lies: Clues to deceit in the marketplace, politics, and marriage

Microexpression identification and categorization using a facial dynamics map

Learning from hierarchical spatiotemporal descriptors for micro-expression recognition

Domain regeneration for cross-database micro-expression recognition